Am Anfang des Propädeutikums schwirrten mir viele Gedanken durch den Kopf:

Was bringt es; wird es mir zeigen, ob das Studium die richtige Entscheidung darstellt; hoffentlich werde mit den anderen Bereichen nicht zu überfordert sein..

Dementsprechend kurz und vage fiel mein erster Blogbeitrag aus.

Zu Beginn befassten wir uns ganz allgemein mit dem Begriff des Web und versuchten zu erörtern, was es ist und was es darstellt.

Außerdem erforschten wir die ersten Entwicklungen im europäischen als auch im amerikanischen Raum.

Aber nicht nur die Vergangenheit, sondern auch die Zukunft wurde eingehend von uns beleuchtet.

Aufgrund des Besuches von Ted Nelson widmeten wir uns verstärkt dem Begriff des Hypertextes- dem Link. Auf den ersten Blick etwas vollkommen Banales, doch ist es faszinierend die Entwicklung und die Idee dahinter zu verfolgen.

Am nächsten Tag durften wir an einer spannenden Führung durch das AEC teilnehmen.

Weiters ergründeten wir einen mir vollkommen neuen Bereich, nämlich der Gestaltung und des Designs des Internets. Nach anfänglichen Problemen fand ich mich aber mit der HTML Übung relativ gut zurecht und habe anschließend auch mit viel Freude meinen Blog umgestaltet.

Ein weiterer Gesichtspunkt des Studiums beleuchtete die wirtschaftlichen Aspekte und zeigte uns, wie das Web unzählige Möglichkeiten schafft Produkte zu verkaufen, denen man am „realen“ Markt nie eine Chance gegeben hätte.

Erst zum Schluss des Propädeutikums kamen wir zu einem Themengebiet, das mir teilweise vertraut ist.

Wir diskutierten sowohl die Probleme des Copyrights als auch des Datenschutzes.

Aufgrund der Aktualität der Thematik setzte ich mich außerdem mit dem Begriff der Online-Überwachung auseinander.

Auch die Problematik der Meinungsfreiheit wurde kurz angeschnitten, was mir allerdings nicht ausreichend genug war, weshalb ich selbst ein bisschen zu recherchieren begann.

Als Resümee kann ich sagen, dass mir die angeschnittenen Bereiche nun nicht wirklich nahe und vertraut sind, mein Interesse an der weiteren Erforschung wurde allerdings geweckt und ich freue mich schon auf die allgemeinen Grundlagenkurse, die die anderen Themengebiete eingehender präsentieren werden.

Der „Sinn“ des Propädeutikum ist mE einen groben Überblick über die verschiedenen Richtungen zu liefern und dem Studenten so ins Gedächtnis zu rufen, dass „Surfen im Netz“ aus zahlreichen Komponenten besteht, die einem so gar nicht bewusst sind.

Die Online-Durchsuchung ermöglicht es den Ermittlungsbehörden auf die Festplatte des Computers eines potenziellen Straftäters mit Hilfe einer während der Internet-Nutzung installierten Software, einem sog. „Trojaner“, zuzugreifen. Diese Software übermittelt sodann die auf der Festplatte gespeicherten Daten an die Behörde.1

Zwar können die Staatsanwaltschaft oder die Polizei auch im Rahmen einer gewöhnlichen Hausdurchsuchung bzw. Beschlagnahme des PCs an die darauf gespeicherten Daten gelangen. Der Vorteil der Online-Durchsuchung liegt aber darin, dass sie heimlich und über einen längeren Zeitraum erfolgen kann.

Obwohl es in Österreich derzeit keine gesetzliche Grundlage für die Durchführung von Online-Durchsuchungen wurde von den Urhebern der Software ein Ankauf aus Österreich bestätigt.2

Es ist daher dringend zu klären ob bzw. welche Software gekauft wurde und inwiefern sie zum Einsatz kommen soll.

1: http://www.spiegel.de/lexikon/55567016.html

2: http://orf.at/stories/2084135/

Creative Commons bestehen aus einem Bündel von Standard-Lizenzverträgen, mittels derer Autoren der Öffentlichkeit Nutzungsrechte an ihren Werken einräumen können. Darunter fallen Bilder, Fotos, Musikstücke, Kompositionen etc.

Diese Lizenzverträge unterscheiden sich vom herkömmlichen Urheberrecht bzw. Copyright in der Abstufung der Freiheitsgrade.

Auf diese Weise erhalten Nutzer und Urheber Rechtssicherheit darüber, in wieweit die Inhalte verwendet werden dürfen. Ein weiteres Charakteristikum der Lizenzverträge ist, dass sie auch für juristische Laien verständlich sind.

Es gibt vier Lizenzbausteinen:

![]() Namensnennung des Urhebers (der Autor muss genannt werden)

Namensnennung des Urhebers (der Autor muss genannt werden)

![]() Nutzung des Inhaltsnur zu nicht-kommerziellen Zwecken (Verkauf verboten)

Nutzung des Inhaltsnur zu nicht-kommerziellen Zwecken (Verkauf verboten)

![]() Keine Bearbeitung des Originals (Veränderung verboten)

Keine Bearbeitung des Originals (Veränderung verboten)

![]() Weitergabe unter gleichen Bedingungen (gleiche Lizenz bei Weitergabe)

Weitergabe unter gleichen Bedingungen (gleiche Lizenz bei Weitergabe)

Hieraus entstehen 6 verschiedene Lizenzkombinationen:

Bild:http://www.masternewmedia.org/images/creative-commons-license-types-pros-cons.gif

Für weitere Informationen siehe auch hier.

Quellen:

1: http://net.educause.edu/ir/library/pdf/ELI7023.pdf

Hypertext kann als die Grundlage des World Wide Web bezeichnet werden. Die Idee dahinter ist ein elektronischer Text über den eine Struktur aus Ankern und Verknüpfungen gelegt wird. Die darin markierte Stelle bildete den „Link“, mit dessen Hilfe man von einem Begriff zum nächsten springen kann. Bei diesem Verweis kann es sich um einen schriftlichen Text, eine Datei, einen Film, ein Bild etc. handeln. Hypertext kann somit als moderne Form der Fußnote bezeichnet werden.

Bild: http://bid.ankara.edu.tr/yardim/www/guide/guide.02.html

Entwicklung

Zum Verständnis des Hypertexts ist es hilfreich, seine Entwicklung näher zu betrachten. Hier werden kurz die Meilensteine des Hypertext-Ansatzes vorgestellt:1

Memex:

Die Hypertext-Idee beruht auf den Visionen Vannevar Bushs.

Bush beschrieb 1945 Memex als eine Maschine zum Blättern und Anfertigen von Notizen in riesigen Textmengen, die mittels Microfiche Kommentare und Zusatznotizen speichern sollte. Mit Memex verfolgte Bush eine Analogie zwischen dem assoziativen Arbeiten des menschlichen Gehirns und dem assoziativen Vernetzen von Texten im Auge.

Augment:

1962 veröffentlichte Douglas Engelbart am Stanford Research Institute den Bericht über das SRI Project No. 3578 „Augmenting Human Intellect : A Conceptual Framework“. Es wurde zunächst für Großrechnerumgebungen konzipiert und war später auch für Workstations verfügbar. Es enthält bereits moderne Ansätze wie Grafikunterstützung und Mausbedienung, sowie erweiterte Funktionen für Telekommunikation.

Xanadu:

Fast gleichzeitig mit Engelbart entwickelte Ted Nelson (1967) das Hypertext-System Xanadu. Nelson stellt sich unter "Xanadu" eine Informationsbank von unbegrenzter Größe vor, dessen Ziel es ist sämtliche Literatur der Welt zu vernetzen, was allerdings nie ganz realisiert wurde. Das auch heute noch utopisch anmutende Endziel ist die Verwaltung des gesamten Weltwissens über ein einziges computerunterstütztes Portal, das den Zugriff auf die entsprechenden informationellen Einheiten gestattet.

HTML:

Timothy Berners-Lee, der Ende der 1980er Jahre im Kernforschungszentrum CERN in der Schweiz arbeitete, schlug 1989 dem CERN ein Projekt vor, das Computer verschiedener Netzwerke miteinander verbinden und kommunizieren lassen sollte. Sein Ziel war ein auf viele Server verteiltes und von vielen Quellen bereitgestelltes und allgemein zugängliches Netz von Wissen und Forschungsergebnissen aufzubauen. Berners-Lee entwickelte dafür die Auszeichnungssprache HTML und schuf dafür den ersten Browser, den er „WorldWideWeb“ nannte und der später dem gesamten Webserver-Netz innerhalb des Internets den Namen geben sollte. Damit begann ab etwa 1993 der Ursprung des WWW.

Timeline

„Vom Hundertsten ins Tausendste“

Das Hauptproblem bei Hypertext ist die Orientierung im bzw. die Navigation durch das komplexe System. Häufig weiß der Nutzer nicht mehr, wie er überhaupt zu der aktuellen Seite gekommen ist bzw. zur vorherigen zurückkommt, da er durch das Anklicken zahlreicher Links viele Ebenen durchwandert und immer mehr die Orientierung verliert. Dieses Phänomen wird auch als "Lost in Hyperspace" bezeichnet.2

Abhilfe können hier jene Mechanismen schaffen, die auch für Printmedien verwendet werden, zB Inhaltsverzeichnisse, Register, Glossare oder Fußnoten. Spezielle Orientierungshilfen für Hypertexte wie Suchfunktionen, Sitemap, Lesezeichen, History oder Tabbed Browsing können die Desorientierung des Lesers lindern.3

Das Internet – unendliche Weiten…

Meinungsfreiheit ist eines der höchsten Güter der heutigen Gesellschaft.

Durch das Internet nimmt sie nun einen noch viel höheren Stellenwert ein, denn heute ist es so einfach wie nie zuvor, Informationen und Ideen global auszutauschen. Gästebücher, Online-Foren, Blogs usw. bieten jedem Internetbenutzer die Möglichkeit, seine persönliche Meinung mit einfachen Mitteln einem großen Publikum mitzuteilen.

Zensur

Zensur bewahrt die Bevölkerung vor staatsfeindlichen Inhalten und kann auch die Weitergabe von manipulierenden und negativ beeinflussenden Web-Seiten verhindert. Dies ist vor allem für den Schutz der Jugendlichen wichtig.1

Es ist allerdings schwer, festzulegen, was zensurwürdig ist und was nicht. Wem obliegt diese Entscheidung- die Regierung, das Gericht, die Provider oder der einzelne User? Auch ist die Umsetzung der Zensur nicht so leicht durchführbar, da die Verbreitung einfach zu schnell erfolgt und teilweise die Spuren nicht nachverfolgt werden können.

Während wir in den westlichen Ländern uns mit Themen der Zensur hinsichtlich Pornografie und Schutz von Minderjährigen auseinandersetzen, gibt es in vielen anderen Ländern der Erde weit größere Probleme. Über 60 Länder zensieren ihre Bürger nämlich rigoros.2

Dies reicht von Social Medias bis zu Webseiten, die die Themen Alkohol, Sexualität, Glücksspiel und Pornographie beinhalten und teilweise beschränkt sich der Zugang nur auf Seiten die die jeweilige Führung verherrlichen.

Bild: http://tugll.tugraz.at/31368/files/-1/1200/internet_zensur.png

Bekämpfung

Bei Sperrungen können, je nach technischer Umsetzung der Zugriffssperre, mittels Provider-fremder Systeme wie Proxy-Server, Freenet oder der Virtual-Private-Network-Technik umgangen werden. Diese Werkzeuge sind für die Zensoren aber relativ leicht zu blockieren. Um diese Techniken zu nutzen, bedarf es stets einer Adresse im Ausland, mit der man sich dann verbinden kann. Und diese IP lässt sich dann ebenso sperren, sobald die Zensurbehörde davon Wind bekommt. Daraus resuliert ein eine Art Katz-und-Maus-Spiel.

Um diese radikale Zensur zu bekämpfen wurde von amerikanischen Forschern TELEX entwickelt, ein „Superproxy“ der nicht über einzelne IP-Adressen oder Domains agiert, sondern so vielfältig verschichtet ist, dass er den Zensoren nicht auffällt.

Möchte der Nutzer eine zensierte Website besuchen, baut die Anwendung eine Verbindung zu einem nicht gesperrten Webserver außerhalb des Zensurnetzwerks auf. Die Telex-Anwendung markiert die Verbindung im Geheimen als Telex-Anforderung und passieren spezielle Router die mittels eines Entschlüsselungscodes die getaggten Verbindungen erkennen und entschlüsseln können. Diese Stationen lenken dann die Verbindungen zu Antizensur-Diensten wie Tor-Diensten um, über der Nutzer dann die blockierten Webseiten besuchen kann.3

1: http://www.bildung.at/home/news/2011/new-node-7/

2: http://woorkup.com/2010/06/27/internet-censorship-report/

3:http://futurezone.at/netzpolitik/4466-telex-das-neue-gegenmittel-fuer-zensur-im-netz.php

Für weitere Informationen siehe auch:

http://www.reporter-ohne-grenzen.de/fileadmin/rte/docs/2011/110311_Internetbericht_engl.pdf

Dieser Beitrag beschäftigt sich mit ein paar Gedanke der zukünftigen Entwicklung des Internets.

Zweiklassengesellschaft

Weil es immer mehr Engpässe im weltweiten Datenverkehr gibt und dies in Zukunft noch steigen wird befürchten viele das Ende der Netzneutralität. Netzneutralität bedeutet wertneutrale Datenübertragung. Alle Datenpakete werden unverändert und gleichberechtigt übertragen, unabhängig davon, woher sie stammen.

Man befürchtet, dass bald derjenige bevorzugt behandelt wird, der extra dafür bezahlt. Die anderen müssen warten.1

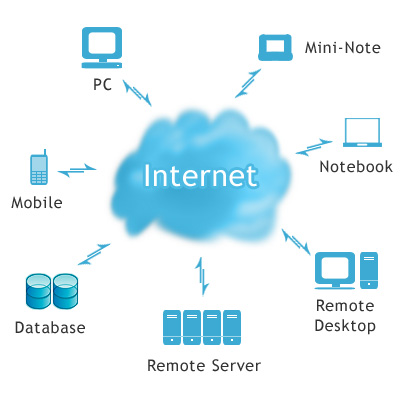

Der Grundgedanke beim Cloud Computing ist, dass alle Anwendungen im Web laufen- von einfacher Software bis hin zu kompletten Betriebssystemen. Statt eines echten Servers mietet man eine virtuelle Maschine, deren Speicher- und Prozessorausstattung sich dynamisch den Anforderungen entsprechend vergrößert oder verkleinert.2

Die Vorteile der Wolke, bei der die abstrahierte IT-Infrastruktur für eine flexible Nutzung von Daten und Programmen sorgt, werden vor allem in verringerten Kosten, der hohen Flexibilität, der Ortsungebundenheit und der Ressourceneffizienz gesehen.

Das große Problem ist allerdings die Sicherheit der Daten. Von der fehlenden Transparenz von Daten, die sich irgendwo in der Cloud befinden und vom Nutzer nicht mehr zurückverfolgt werden können bis hin zur Vermengung von Daten der verschiedenen Nutzer, kann es zu signifikanten Problemen bei der Einhaltung von Datenschutz kommen.3

Weiterhin ist die Abhängigkeit der Kunden vom Dienstbetreiber kritisch zu betrachten- Was passiert, wenn Cloud-Server ausfallen? Wer haftet bei Datenverlust? Wo werden die Daten gespeichert?

Unzählige Fragen auf die es bis jetzt kaum befriedigende Antworten gibt.

Bild: http://www.trendcomputing.de/wp-content/uploads/2010/12/cloud1.jpg

Web x.0

Web 2.0

Im allgemeinen Sprachgebrauch versteht man unter Web 2.0 das so genannte “neue Netzverständnis”.

Darunter fallen Flickr, YouTube oder Wikipedia. Man teilt Informationen, indem man sie allen auf einer gemeinsamen Plattform zur Verfügung stellt, das gemeinsame Arbeiten aber auch das Tagging im Sinne eines gemeinschaftlichen Indexieren steht hier im Vordergrund.4

Web 3.0 stellte eine Emanzipation von Autor, Inhalt, Raum und Zeit durch die Trennung fester Bindungen und Bezüge dar. Die Daten werden so strukturiert, das es Computern ermöglicht wird, sie entsprechend ihrer inhaltlichen Bedeutung zu verarbeiten.

1: http://www.spiegel.de/thema/netzneutralitaet/

2: http://de.wikipedia.org/wiki/Cloud_Computing

3: http://www.scip.ch/?labs.20091127

4: http://content.webmanufacture.org/das-neue-netzverst%C3%A4ndnis

Link 1: http://www.youtube.com/watch?v=GctHV_AlZHw&feature=related

Denkt man an die technischen Entwicklungen des Web, fällt einem wohl zuerst der Begriff "Silicon Valley" ein.

Doch die Vorreiter die elektronische Netzwerke erstmals zum Austausch von Daten und Informationen nutzten, waren 1983 die Franzosen.

Fast 30 Jahre gibt es dieses auf den Telefonnetz basierende Netzwerk schon. Man konnte Nachrichten verschicken, Tickets bestellen, Datenbanken verwalten oder einfach nur chatten.

Revolutionär zu dieser Zeit- da erstaunt es umso mehr, dass es eigentlich nur entwickelt wurde, weil man keine Telefonbücher mehr drucken wollte- die Herstellung der Apparate war wesentlich billiger und um die Beliebtheit zu steigern, wurden sie sogar kostenlos verteilt.1

Da es allerdings kaum Veränderungen und Weiterentwicklungen gab, geht das Minitel nun nach fast 30 Jahren in "Pension" und wird Mitte 2012 eingestellt.2

1: "Bildschirmfieber" von Marie-Rose Bobi und Michael Busse. Eine Produktion des NDR, gesendet vom ORF am 17. Oktober 1987."

"Medien sind in einem weiten Sinne alle Vermittlungsformen von Welt, wie die Sprache, traditionelle Medien wie das Buch oder das Bild, aber auch alle mit Hilfe von Technik ermöglichten Formen der Kommunikation wie Fernsehen, Computerspiele oder Internet."1

Obwohl hinsichtlich der tatsächlichen Einordnung der Web als Medium keine Einigkeit herrscht, ist dennoch erstaunlich, dass es von den Verbrauchern definitv als solches gesehen wird- und zwar als Nummer 1.

Für Internetnutzer ist das Web zum wichtigsten Medium geworden. Drei Viertel erklären, nicht auf darauf verzichten zu können. Gefolgt von Fernsehen (70 Prozent), Büchern (67 Prozent), Radio (65 Prozent), Zeitungen und Zeitschriften sowie Handys (jeweils 63 Prozent).2

Vergleicht man die Vorstellungen von der Zukunft vor vielen Jahren, mit der "Zukunft" wie sie nun gegeben ist, entdeckt man erstaunliche Parallelen bzw. dass viele Visionen auch tatsächlich realisiert wurden.

Obwohl der Apple Knowledge Navigator 1987 bloß als Spinnerei erachtet wurde, die so fantastisch war, dass man nie glaubte, sie je wirklich zu realisieren, kann man heute feststellen, dass es diesen navigator sogar tatsächlich gibt.

Natürlich sind nicht alle Funktionen 1:1 verwirklicht worden, aber größtenteils erkennt man darin Apples Produkte wie das Macbook, oder das Ipad.

Man navigiert über ein Touch Display, es gibt Videotelefonie, und das Format des PCs ist sogar um einiges handlicher und leichter. Und die Techniker und Wissenschaftler tüfteln fleißig an immer beeindruckenderen Innovationen.

Dieses Video zeigt neben dem Knowledge Navigator noch weitere "Visionen" von Apple.

Video: http://www.youtube.com/watch?v=9bjve67p33E

"Google Maps mit Street View bietet Ihnen die Möglichkeit, Orte auf der ganzen Welt in einer 360-Grad-Ansicht auf Straßenebene zu erkunden. Sie können sich Restaurants anschauen, sich in Stadtvierteln umsehen oder Ihre nächste Reise planen.“1

Die dafür erforderlichen Bilder werden von auf Fahrzeugen mit montierten Kameras aufgenommen, die öffentliche Wege und Straßen abfahren und währenddessen ihre Aufnahmen für den Internetservice machen.

Kritik2

Missbrauchsgefahr:

Die enthaltenen Daten laden zum Missbrauch ein, sagen die Kritiker. Kriminelle könnten mittels Internet völlig anonym die Lage von Häusern und erreichbare Fenster erkunden. Firmen wiederum können den Dienst für unerwünschte Werbung nutzen.

Privatsphäre:

Bei der gewinnung der Daten ist es unvermeidlich, dass auch Passanten und Fahrzeuge mit erfasst und fotografiert werden. Um die Angst vor dem Verlust der Privatsphäre zu dämmen versichert dem Google, dass Gesichter und Autokennzeichen vor der Veröffentlichung in Street View verpixelt und unkenntlich gemacht werden.

Ob dies allein Schutz bietet ist fraglich- Personen könnten trotzdem an ihrer Kleidung identifiziert werden, was auch für Autos gilt, selbst wenn die Kennzeichen verpixelt sind.

Und auch wenn das Abfotografieren von Gebäuden grundsätzlich erlaubt ist, gibt es hier bedenken- Die Kameras auf den Google-Autos sind in einer Höhe von über 2,50 Meter montiert und können somit über Hecken und Gartenzäunen blicken und fotografieren.

Sicherheitsbedenken:

Obwohl ersonen unkenntlich gemacht werden sollen gibt es berechtigte Bedenken, denn die Software, die Menschen an Augen, Nase und Mund erkennen soll, hat keine hundertprozentige Erfolgsquote.

Österreich

Als im 2010 bekannt wurde, dass Google bei den Street View-Fahrten auch WLAN Daten ermittelt hatte und noch dazu dabei Inhaltsdaten von E-Mails aufgezeichnet hatte, wurde von der Datenschutzkommission ein Prüfverfahren eingeleitet, woraufhin Google die Inhaltsdaten gelöscht hat.

Für die Datensammlung in Österreich wurden nun 3 zusätzliche Auflagen erlassen:3

1) Bei Aufnahmen von Personen in besonders sensiblen Bereichen sind nicht nur deren Gesichter, sondern die Gesamterscheinung der Personen unkenntlich zu machen. Dazu zählen insbesondere die Eingangsbereiche von Kirchen, Gebetshäusern, Krankenhäusern, Frauenhäusern und Gefängnissen.

2) Bildaufnahmen privater nicht einsehbarer Immobilien, wie insbesondere umzäunter Privatgärten und -höfe, sind vor einer Veröffentlichung im Internet unkenntlich zu machen.

3) Betroffene haben ab dem Zeitpunkt der Ermittlung der Daten ein Widerspruchsrecht. Um dieses bereits vor der Veröffentlichung der Daten von Gebäuden zu ermöglichen, müssen geeignete Werkzeuge zur Verfügung gestellt werden.

Die ersten beiden Empfehlungen muss Google bis zur Veröffentlichung der Daten im Internet umsetzen. Das Werkzeug zum Widerspruchsrecht und der Hinweis darauf sind mindestens zwölf Wochen vor Veröffentlichung der Daten im Internet zur Verfügung zu stellen.

Datenschutz nach Google:

Video: http://www.youtube.com/watch?v=ji63biVGcbY&feature=player_embedded

1: http://maps.google.at/intl/de/help/maps/streetview/faq.html

Dies ist mein erster Beitrag in diesem Blog- meine ersten wackeligen Schritte „in die Tiefen des WWW“.

Obwohl ich mich als offenen und modernen Menschen erachte, der im Umgang mit „Social Media“ relativ geübt ist, gibt es dennoch unzählige Bereiche die mir fremd sind, denn das Studium setzt sich aus vielen verschiedenen Teilen zusammen, die ein großes komplexes Ganzes ergeben.

Gerade im Bereich der Rechtswissenschaften (meinem gewählten Zweig) kommen durch die stetigen Entwicklungen immer neue Bereiche hervor bzgl. derer es (noch) keine konkreten Regelungen gibt.

Allerdings ist es mir auch wichtig andere Aspekte des WWW kennen und verstehen zu lernen.

Mit diesem Studium hoffe ich, neue Einblick zu gewinnen, die mir auch in meiner beruflichen Laufbahn von Nutzen sein werden.