Artikel Netzneutralität aus technischer Perspektive

christoph.linimayer.uni-linz, 16. April 2016, 17:04

Was ist Netzneutralität?

Der Begriff „Netzneutralität“ kann auf unterschiedliche Art und Weise definiert werden. Eine Möglichkeit besteht darin die Netzneutralität über das Ende-zu-Ende-Prinzip des Internets zu definieren.

Barbara van Schewick, eine angesehene deutsche Informatikerin, schreibt: „Grundlage der Argumente all jener, die die innovationsfördernde Architektur des Internets erhalten wollen, ist die Feststellung, dass das Internet aufgrund des End-to-End-Prinzips ein neutrales Netzwerk darstellt, das nicht in der Lage ist, Anwendungen an seinen Rändern auszuschließen oder ihre Ausführung zu behindern. Gegenläufig dazu wird es Netzbetreibern im Zuge neuer technologischer Entwicklungen möglich, bestimmte Anwendungen unter Verletzung der End-to-End-Architektur des Internets zu diskriminieren.“ (vgl. Q1, S.49)

Eine weitere Möglichkeit besteht darin, den Begriff aus Sicht des Benutzers zu beschreiben. Tim Berners-Lee hält hierzu auf seinem Blog folgende Definition fest: „If I pay to connect to the Net with a certain quality of service, and you pay to connect with that or greater quality of service, then we can communicate at that level.“ (vgl. Q2)

Die digitale Gesellschaft erklärt den Begriff sehr einfach und anschaulich wie folgt: „Grundsätzlich werden Daten im Internet gleich gut oder schlecht behandelt. Es gibt also keine Rangfolge: Keiner schaut, von wem sie kommen, keiner schaut, wohin sie gehen, keiner schaut, was für Arten von Daten es sind und keiner schaut, ob diese Daten wichtig sind. Stattdessen transportieren die Knoten und Anbieter im Internet die Daten nach bestem Wissen und Gewissen von A nach B.“ (vgl. Q3)

Wie funktioniert der Datenaustausch im Internet derzeit?

Vereinfachte Erklärung

Bei jeglicher Interaktion im Internet, egal ob beim Senden / Empfangen einer Email, beim Online-Shopping oder beim Streamen von Musik / Video werden die Inhalte in Datenpakete zerlegt und über technisch normierte Internetprotokolle zwischen dem PC und einem (oder mehreren) Server(n) ausgetauscht. Die Datenpakete erhalten vom Absender einen „Header“ (mit Informationen zum Absender und Empfänger), ähnlich wie bei einem Brief, damit die Pakete auch ankommen. Der Internet Service Provider (ISP) routet die einzelnen Pakete in zufälliger Reihenfolge und nach dem Best-Effort-Prinzip weiter. Das bedeutet, dass sie im Rahmen verfügbarer Ressourcen schnellstmöglich weitergeleitet werden, unabhängig von Inhalt, Absender, oder anderer Faktoren. Es besteht jedoch keine Garantie auf Vollständigkeit bzw. Fehlerfreiheit bei der Übermittlung der Pakete. Daher kann es vorkommen, dass einzelne Teilpakete mehrfach angefordert werden müssen. (vgl. Q4)

Detaillierte Erklärung

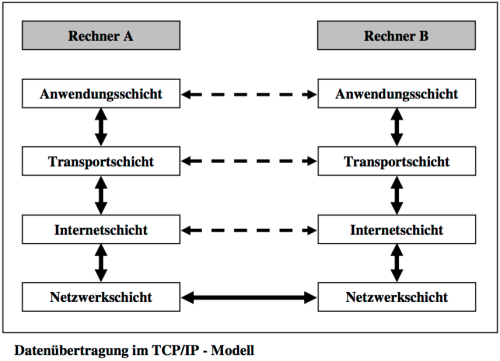

Bei der Übertragung von Daten im Internet müssen diverse aufeinander folgende Aufgaben abgearbeitet werden. Das TCP/IP-Modell teilt diese in vier Gruppen ein (Anwendungsschicht, Transportschicht, Internetschicht und Netzwerkschicht).

Diese einzelnen Aufgabenschritte sind hierarchisch angeordnet, was bedeutet, dass sich jede Schicht nicht kümmern muss, was in den darunterliegenden Schichten geschieht.

In nachfolgender Grafik ist erkennbar, wie die Übertragung von Daten in dem Schichtenmodell abläuft. Beim Sender werden die vier Schichten von oben nach unten durchlaufen, indem die Daten von einer Schicht zur nächsten weitergereicht werden. Der Empfänger durchläuft die Schichten in genau der umgekehrten Reihenfolge. Die gestrichelten Linien zwischen den Schichten des Senders und Empfängers sollen andeuten, dass jede Schicht eines Rechners mit der gleichen eines anderen Rechners kommunizieren kann, wobei eine physikalische Verbindung zwischen Sender und Empfänger nur in der Netzwerkschicht besteht. (vgl. Q5)

Anwendungsschicht

In der obersten Schicht werden Regeln festgelegt, wie jene Daten behandelt werden sollen, die versendet werden sollen bzw. empfangen wurden. Diese Regeln werden in Protokollen zusammengefasst. Für die Verarbeitung von Webseiten ist das HTTP-Protokoll, für Emails das SMTP-Protokoll und für Dateien das FTP-Protokoll zuständig. (vgl. Q5)

Damit die Daten am Empfänger vom richtigen Protokoll verarbeitet werden können, fügt das jeweilige Protokoll am Sender Informationen über die Art der Daten zu den Nutzdaten hinzu und übergibt diese an die Transportschicht. Diese Zusatzdaten werden Kopfdaten oder Headerdaten genannt.

Transportschicht

In der Transportschicht existieren weitere Regeln, welche für den Versand und Empfang von Daten notwendig sind. Diese sind in einem Protokoll, dem TCP-Protokoll zusammengefasst.

Dieses Protokoll stellt eine Verbindung zum Empfänger her, indem es mit dessen TCP-Protokoll kommuniziert. Hierbei wird kontrolliert, ob die Daten fehlerfrei und vollständig übertragen wurden.

Das TCP-Protokoll erweitert die Kopfdaten um weitere Daten, damit beispielsweise fehlerhafte Übertragungen erkannt werden können, wandelt alle zu sendenden Daten ins Binärformat um und gibt diese schlussendlich an die Internetschicht. (vgl. Q5)

Internetschicht

Das Protokoll in der Internetschicht wird IP-Protokoll genannt, welches die von der Transportschicht erhaltenen Daten in Datenpakete aufteilt. Jedes dieser Pakete enthält somit einen Teil der zu übertragenden Daten und zusätzlich Kopfdaten. Darin sind beispielsweise die IP-Adresse des Senders und des Empfängers enthalten.

Das IP-Protokoll übergibt die Datenpakete an die Netzwerkschicht und überwacht den Versand der Pakete an die korrekte IP-Adresse. (vgl. Q5)

Netzwerkschicht

In dieser Schicht findet die tatsächliche (physikalische) Übertragung der Pakete statt. Die Art und Weise wie dies geschieht, wurde im IP-Protokoll in der Internetschicht festgelegt. (vgl. Q5)

Wie kann in diesen neutralen Austausch eingegriffen werden?

In den im vorangehenden Abschnitt beschriebenen Prozess des Datenaustausches im Internet kann an verschiedenen Stellen mit unterschiedlichen Techniken bzw. Verfahren regulierend eingegriffen werden. Dazu zählen die Statefaul Packet Inspection, die Deep Packet Inspection und auch die Quality of Service.

Stateful Packet Inspection (SPI)

Bei der Stateful Packet Inspection (auf Deutsch: zustandsorientierte Paketüberprüfung) wird in der Netzwerkschicht der Header jedes einzelnen Pakets betrachtet und überprüft ob das Paket zu einer gültigen Session gehört.

Dieses Verfahren wird sehr häufig von Firewalls durchgeführt. Sie überprüfen, ob das Paket in das interne Netzwerk weitergeleitet werden soll, indem sie das Paket inspizieren, um zu erfahren, welche Verbindungen innerhalb des Netzwerks zum Internet aufgebaut wurden. Sofern eine offene Verbindung vorhanden ist, welche mit der des empfangenen Pakets übereinstimmt, wird es von der Firewall in das interne Netzwerk durchgelassen. Wenn dies nicht der Fall ist, wird es vernichtet. (vgl. Q6)

Bei dieser Methode könnten die Datenpakete gezielt auf Daten im Header überprüft werden und sofern sie vorhanden sind bevorzugt behandelt werden. Der Nachteil darin besteht jedoch, dass bei Bekanntwerden der notwendigen Daten, theoretisch zu jedem Paket diese Daten hinzugefügt werden können.

Deep Packet Inspection (DPI)

Im Gegensatz zur Stateful Packet Inspection wird hier nicht nur der Headerteil der Datenpakete überprüft, sondern der tatsächliche Inhalt, der Datenteil. So kann gezielt auf Protokollverletzungen oder Computerviren geprüft werden. Außerdem können dadurch Datenströme reguliert werden. Diese Methode wird unteranderem zur Vorratsdatenspeicherung, zum Abhören und Sammeln von Informationen und zur Zensur im Internet eingesetzt. (vgl. Q7)

Die digitale Gesellschaft beschreibt Deep Packet Inspection anhand eines sehr guten Beispiels: „Stellen Sie sich vor, die Post öffnet alle Ihre Briefe und liest den Inhalt. Manche schreibt sie um – und andere schmeißt sie einfach weg. Das klingt absurd? Genau das passiert mit Ihren Daten im Internet.“ (vgl. Q3)

Diese Methode könnte sehr einfach verwendet werden, um Pakete mit bestimmten Inhalten oder von bestimmten Absendern bevorzugt zu behandelt. Eine Manipulation ist daher nahezu unmöglich.

Quality of Service (QoS)

Die Idee von Quality of Service besteht darin Übertragungsraten, Feherraten und andere Eigenschaften zu berechnen, zu verbessern und auch bereits im Voraus garantieren zu können. Von besonderer Bedeutung ist dies bei Streaming-Diensten, welche eine kontinuierliche Übertragung von Videos mit hoher Bandbreite benötigen, welches jedoch mit Best-Effort-Protokollen schwierig zu bewerkstelligen ist. (vgl. Q8)

Mit dieser Methode wäre es denkbar verschiedene Service-Levels anhand funktionaler Kriterien zu unterteilen und unterschiedlich zu bepreisen. (vgl. Q9)

Quellen:

Q1: http://www.wissensgesellschaft.org/themen/wissensoekonomie/OpenInnovation.pdf

Q2: http://dig.csail.mit.edu/breadcrumbs/node/144

Q3: https://digitalegesellschaft.de/wp-content/uploads/2012/10/dg_dpi_FINAL1.pdf

Q4: http://www.informatik.uni-leipzig.de/~graebe/Texte/Bachmann-Vollers-14-Folien.pdf

Q5: http://www.rg71.de/informatik/alt/Jahrgang%2011/Alt/Daten%FCbertragung%20im%20Internet.pdf

Q6: https://www.zen.co.uk/business/broadband/business-broadband/stateful-vs-deep-packet-inspection.aspx

Q7: https://de.wikipedia.org/wiki/Deep_Packet_Inspection

Q8: http://www.searchnetworking.de/definition/Quality-of-Service-QoS

Q9: http://publikationen.collaboratory.at/mri/netzneutralitaet/

Alle Quellen wurden zuletzt am 03.04.2016 10:00 Uhr abgerufen.

0 comments :: Kommentieren